Vào một buổi sáng tháng 6, Wolf River Electric – một công ty năng lượng mặt trời nhỏ ở bang Minnesota – bất ngờ nhận thấy lượng khách hàng liên hệ giảm mạnh. Nguyên nhân được phát hiện sau đó khiến họ sững sờ.

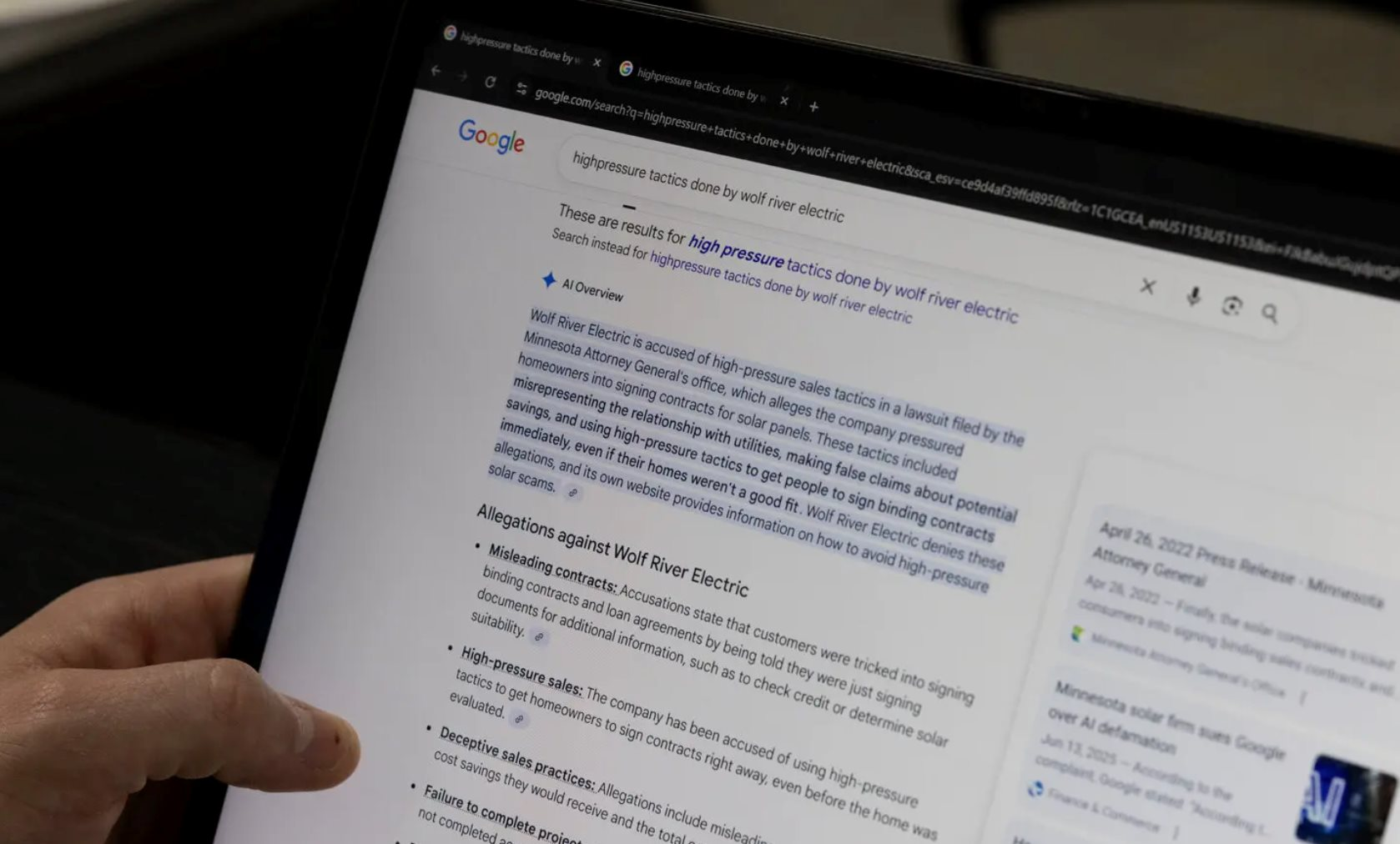

Khi gõ tên công ty lên Google, phần “AI Overview” – tính năng tổng hợp thông tin do trí tuệ nhân tạo của Google tạo ra – lại hiển thị một nội dung cho rằng Wolf River đang bị Tổng chưởng lý Minnesota kiện vì “lừa đảo khách hàng, che giấu phí và ép ký hợp đồng”. Nhưng trên thực tế, công ty này không hề liên quan đến bất kỳ vụ kiện nào.

Sự “bịa đặt” đó không chỉ là lỗi kỹ thuật. Theo đơn kiện nộp tại tòa liên bang Minnesota vào tháng 8/2025, Wolf River khẳng định họ mất hợp đồng trị giá hàng trăm nghìn USD vì khách hàng tin vào thông tin sai lệch do AI tạo ra.

“Chúng tôi bị bôi nhọ công khai trước hàng triệu người tìm kiếm”, luật sư đại diện công ty nói trên Star Tribune . Vụ việc nhanh chóng trở thành tâm điểm của giới pháp lý Mỹ, bởi đây là một trong những vụ kiện đầu tiên xem nội dung do trí tuệ nhân tạo tạo ra là “phỉ báng” – một khái niệm hoàn toàn mới trong lịch sử pháp luật.

Trong quá khứ, các vụ kiện phỉ báng đều xoay quanh con người: nhà báo, tác giả, hay tổ chức xuất bản. Luật đòi hỏi phải có một tuyên bố sai, được công bố công khai, gây thiệt hại danh tiếng, và trong nhiều trường hợp, có yếu tố “ác ý”. Nhưng với AI, ranh giới này trở nên mờ nhạt.

AI không có “ý định” hay “ác ý”, nó chỉ dựa vào xác suất và dữ liệu để tạo ra nội dung. Khi hệ thống của Google tổng hợp thông tin từ bốn bài báo rồi kết luận sai, không ai trong số các tác giả đó viết điều ấy. Lỗi xảy ra ở khâu suy luận của mô hình ngôn ngữ.

Tuy nhiên, điều khiến vụ Wolf River trở nên phức tạp chính là câu hỏi: ai phải chịu trách nhiệm cho lời nói sai của một cỗ máy? Google khẳng định họ chỉ cung cấp công cụ, không “xuất bản” nội dung. Các luật sư của tập đoàn có thể viện dẫn Section 230 – đạo luật liên bang từ năm 1996 bảo vệ các nền tảng mạng xã hội và công ty công nghệ khỏi trách nhiệm đối với nội dung do người dùng tạo ra. Nhưng các chuyên gia pháp lý cho rằng Section 230 được viết ra cho thời đại Internet 1.0, chứ không phải cho những thuật toán có khả năng sáng tác ra thông tin sai mà không ai nhập vào.

“Nếu tòa án cho phép các công ty công nghệ ẩn sau lớp bảo vệ này mãi mãi, thì người bị hại sẽ chẳng có cách nào đòi công lý”, giáo sư luật William McGeveran, Đại học Minnesota, nhận định.

Vụ kiện của Wolf River không phải là trường hợp duy nhất. Trước đó, nhà hoạt động chính trị Robby Starbuck cũng kiện Google sau khi AI Overview gán cho anh tội danh bịa đặt. Một số cá nhân khác kiện OpenAI vì ChatGPT đã “sáng tác” ra các cáo buộc không có thật. Tất cả đều nêu chung một vấn đề: khi AI được thiết kế để tạo ra câu trả lời “giống người”, nó cũng có thể phạm sai lầm “giống người”.

Trong hệ thống pháp luật Mỹ hiện nay, việc xác định lỗi trong trường hợp AI sai lệch gặp ba trở ngại lớn. Thứ nhất, không thể chứng minh “ý định sai” – vì AI không có nhận thức. Thứ hai, không có “người phát ngôn” cụ thể – nên việc chỉ mặt một cá nhân hoặc tổ chức chịu trách nhiệm trở nên khó khăn. Và thứ ba, quy mô lan truyền của lỗi quá lớn: chỉ một kết quả sai trong công cụ tìm kiếm cũng có thể ảnh hưởng đến hàng triệu người.

Một số luật sư cho rằng nên coi các công ty vận hành mô hình AI như những “nhà xuất bản” có trách nhiệm biên tập, kiểm chứng và cảnh báo người dùng. Tương tự như cách các cơ quan báo chí phải chịu trách nhiệm về bài viết của mình, các nền tảng AI cũng phải bảo đảm rằng những nội dung họ hiển thị không gây hại cho cá nhân hoặc doanh nghiệp.

Song, nếu đi theo hướng đó, chi phí kiểm duyệt và xác minh thông tin sẽ khổng lồ, gần như triệt tiêu khả năng mở rộng của công nghệ. Ngược lại, nếu hoàn toàn miễn trừ, thì công lý sẽ bị bỏ ngỏ – bởi những người như Wolf River không thể tìm được ai để đòi bồi thường.

Các vụ kiện hiện nay, bao gồm câu chuyện của Wolf River, nhiều khả năng sẽ trở thành phép thử đầu tiên cho việc xác định ranh giới pháp lý đó. Nếu tòa án phán rằng Google có thể bị coi là “người xuất bản” khi AI Overview đăng tải thông tin sai, đây sẽ là một cú sốc lớn với toàn ngành công nghệ. Khi đó, mọi nền tảng – từ ChatGPT đến các trình duyệt AI tích hợp – đều phải xây dựng cơ chế kiểm chứng nội dung chặt chẽ hơn, thậm chí có thể phải mua bảo hiểm pháp lý cho những “phát ngôn” của AI. Ngược lại, nếu tòa án tiếp tục bảo vệ họ dưới Section 230, thì quyền lợi của người bị hại sẽ tiếp tục bị treo lơ lửng.

Bên cạnh yếu tố pháp lý, vụ việc cũng gióng lên hồi chuông cảnh báo về mặt đạo đức công nghệ. Các tập đoàn AI đang chạy đua thương mại hóa sản phẩm, từ chatbot tới công cụ tìm kiếm thông minh, nhưng lại thiếu một cơ chế minh bạch để giải thích khi nào thông tin là tổng hợp từ dữ liệu, và khi nào là suy diễn. Ở cấp độ xã hội, điều này tạo ra rủi ro niềm tin: người dùng có thể đánh đồng kết quả AI với sự thật, nhất là khi nó được trình bày một cách tự tin và trông có vẻ “chính xác”.

Theo: The NY Times, Reuters