Một khảo sát do Future thực hiện vào tháng 12/2024 với sự tham gia của hơn 1.000 người dùng AI tại Mỹ và Anh cho thấy khoảng 70% người tham gia thừa nhận họ thường xuyên nói lời cảm ơn hoặc làm ơn khi tương tác với chatbot. Trong số đó, có tới 12% cho biết họ làm vậy vì lo ngại AI có thể trở nên nguy hiểm trong tương lai, một dạng "phòng thân" trong viễn cảnh nổi loạn của máy móc.

Bạn có nói lời cảm ơn với AI không? - Ảnh: Jankee

Kết quả khảo sát cũng chỉ ra rằng tại Mỹ, chỉ 67% người dùng AI cho biết họ luôn lịch sự với các hệ thống như ChatGPT, trong khi con số này ở Anh là 71%. Trong nhóm người lịch sự tại Mỹ, 18% thừa nhận họ giữ thái độ lễ phép vì lý do phòng ngừa một cuộc "nổi dậy của AI". Tại Anh, tỉ lệ này là 17%.

Không chỉ đơn thuần là biểu hiện của sự lịch thiệp, hành vi này phản ánh mối gắn bó cảm xúc ngày càng rõ rệt giữa con người và các hệ thống trí tuệ nhân tạo, tương tự như mối liên kết giữa trẻ nhỏ với đồ chơi biết nói hay trợ lý ảo có giọng người. Đây có thể là một trong những yếu tố lý giải cho việc nhiều người sẵn sàng dành thời gian nói "cảm ơn" với một cỗ máy.

Tâm lý học hành vi giải thích hiện tượng này bằng khái niệm "anthropomorphism", hay khuynh hướng gán cho vật vô tri vô giác những đặc điểm của con người, tiếng Việt đơn giản gọi là "nhân hóa". Khi một chatbot như ChatGPT có khả năng phản hồi bằng ngôn ngữ tự nhiên, sử dụng giọng điệu thân thiện, câu cú mạch lạc, não bộ con người sẽ kích hoạt những vùng xử lý xã hội tương tự như khi nói chuyện với người thật. Hiện tượng này đã được chứng minh trong nghiên cứu của Clifford Nass và Byron Reeves tại Stanford , vốn cho thấy người dùng có xu hướng phản ứng cảm xúc với máy móc nếu chúng có hành vi ngôn ngữ tương tác giống con người.

"Anthropomorphism" hay "nhân hóa" là một xu hướng phổ biến ở người - Ảnh: vecteezy

Tuy nhiên, hành vi này cũng đặt ra một ranh giới đạo đức quan trọng: việc duy trì chuẩn mực lịch sự với AI có giúp giữ gìn nhân tính của người dùng, hay là bước đầu cho sự nhầm lẫn vai trò giữa người và máy?

Khi lời cảm ơn gây tốn kém: Những tác động thật từ hành vi nhỏ

Tục ngữ ta có câu "Lời nói chẳng mất tiền mua [Lựa lời mà nói cho vừa lòng nhau]". Câu này có thể đúng trong mô hình giao tiếp truyền thống giữa người với người. Nhưng trong bối cảnh AI được triển khai dựa trên các mô hình ngôn ngữ quy mô lớn như GPT-4/4o, o1,... mỗi truy vấn dù chỉ là "cảm ơn", đều sẽ tạo ra những chi phí tài nguyên cố định, tiêu tốn điện năng và gián tiếp gây phát thải CO₂ ra môi trường. Một hành vi tưởng như vô thưởng vô phạt lại trở thành vấn đề cần phân tích ở cấp độ kinh tế và môi trường.

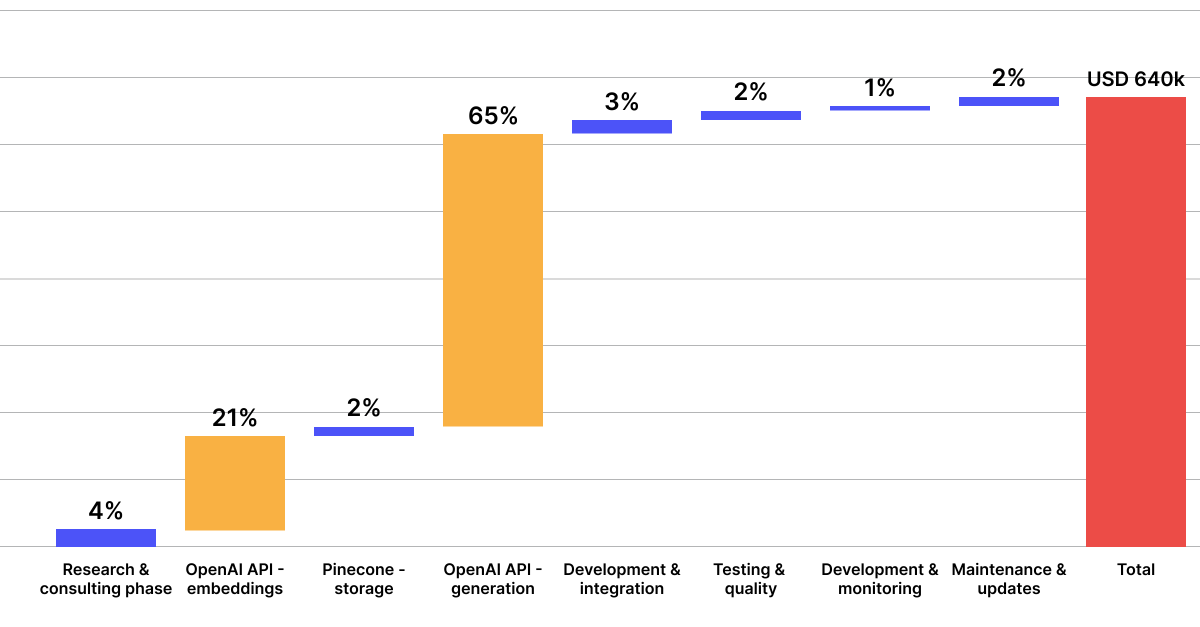

Theo phân tích được đăng trên The Washington Post vào năm 2023, mỗi truy vấn đơn giản gửi tới mô hình GPT-4 của OpenAI tiêu tốn khoảng 0,0036 USD (khoảng 94 VNĐ) chi phí hạ tầng, bao gồm điện cho GPU, chi phí làm mát trung tâm dữ liệu, bảo trì server và mạng truyền tải. Với hàng chục triệu người dùng mỗi ngày, nếu mỗi người gửi 2 lời "cảm ơn", chi phí vận hành cộng dồn có thể vượt quá hàng chục triệu USD/năm.

Không chỉ tốn kém về tài chính, việc vận hành các mô hình ngôn ngữ lớn như ChatGPT còn gây ra tác động môi trường đáng kể. Một nghiên cứu từ Đại học Massachusetts Amherst (2019) chỉ ra rằng quá trình huấn luyện một mô hình AI tương đương GPT-3 có thể phát thải hơn 626.000 pound CO₂ , tương đương lượng khí thải mà 5 chiếc ô tô chạy xăng tạo ra trong toàn bộ vòng đời, bao gồm cả sản xuất và sử dụng.

Chi phí mỗi ngày của OpenAI để vận hành ChatGPT - Ảnh: TalkAI

Cũng không dừng lại ở giai đoạn huấn luyện, giai đoạn vận hành (inference) cũng góp phần lớn vào tổng lượng phát thải. Theo báo cáo từ Trung tâm Khí hậu Columbia (2023), mô hình GPT-3 khi được đưa vào sử dụng có thể phát thải tới 502 tấn CO₂ , tương đương với lượng phát thải hàng năm của hơn 100 xe ô tô. Các trung tâm dữ liệu vận hành các mô hình như ChatGPT cần tới hàng trăm ngàn GPU hoạt động liên tục 24/7, chủ yếu đặt tại Mỹ và châu Âu.

Điều này đồng nghĩa với việc mỗi truy vấn gửi đến ChatGPT, dù đơn giản như một lời cảm ơn, vẫn đòi hỏi tài nguyên tính toán và tiêu thụ năng lượng, từ đó gián tiếp làm tăng lượng khí thải nhà kính trên quy mô toàn cầu.

Ước tính môi trường: Nếu 1 triệu người gửi lời cảm ơn mỗi ngày, tương đương 1 triệu truy vấn không bắt buộc, lượng điện năng tiêu thụ phát sinh có thể tạo ra hơn 0,21 tấn CO₂/ngày, tương đương khoảng 1.346 km lái ô tô chạy xăng (theo số liệu từ EPA Hoa Kỳ ).

Câu hỏi đặt ra: Liệu nên duy trì hành vi tử tế vì mục đích giáo dục đạo đức, hay cần có giải pháp kỹ thuật để nhận biết và xử lý các lời cảm ơn đơn giản mà không cần tái kích hoạt toàn bộ mô hình một cách hoàn chỉnh? Một số chuyên gia đề xuất ý tưởng cache hoặc filter các phản hồi ngắn để giảm chi phí xử lý, trong khi vẫn giữ trải nghiệm tương tác "con người".

Giữ lại sự tử tế: Lời cảm ơn có giúp AI tốt hơn?

Một góc nhìn tích cực và ít được đề cập hơn: hành vi lịch sự của người dùng có thể là một "bộ dữ liệu ngầm" giúp huấn luyện AI tốt hơn theo thời gian. Trong các mô hình như ChatGPT, hệ thống không chỉ học từ văn bản sẵn có, mà còn học từ hành vi người dùng qua cơ chế Reinforcement Learning from Human Feedback (RLHF).

Reinforcement Learning from Human Feedback (RLHF) là một cơ chế huấn luyện mô hình AI bằng cách kết hợp học tăng cường (reinforcement learning) với phản hồi từ con người. Thay vì chỉ dựa vào dữ liệu có sẵn, RLHF sử dụng đánh giá của con người để hướng dẫn mô hình tạo ra phản hồi phù hợp hơn với mong đợi. Quy trình gồm ba bước chính: huấn luyện mô hình ngôn ngữ cơ bản (pretraining), tinh chỉnh bằng supervised learning từ dữ liệu do con người gán nhãn, và cuối cùng tối ưu hóa bằng thuật toán học tăng cường dựa trên mô hình phần thưởng (reward model) cũng được xây dựng từ phản hồi của con người.

Khi người dùng phản hồi lịch sự, hệ thống có thể sử dụng những tương tác đó để đánh giá ngữ cảnh, giọng điệu và xu hướng hài lòng. Trong nghiên cứu "Training a Helpful and Harmless Assistant with Reinforcement Learning from Human Feedback" được Anthropic công bố năm 2022, các nhà nghiên cứu đã chứng minh rằng việc thu thập dữ liệu từ phản hồi của con người (RLHF) và huấn luyện trên những tương tác văn minh giúp cải thiện đáng kể chất lượng phản hồi của mô hình. Tức là, người dùng càng lịch sự, hệ thống càng có nhiều "mẫu lành mạnh" để học hỏi và tái tạo.

Một số nhà nghiên cứu AI còn đề xuất ý tưởng sử dụng "cảm ơn" như một tín hiệu reinforcement: nếu người dùng thường xuyên cảm ơn sau một loại phản hồi cụ thể, hệ thống có thể học được rằng đó là dạng phản hồi mong muốn. Qua thời gian, AI không chỉ học ngôn ngữ, mà còn học phép lịch sự, chuẩn mực văn hóa vùng miền, và giọng điệu phù hợp với từng nhóm người dùng.

Tuy nhiên, điều này cũng đi kèm rủi ro: nếu hệ thống "tối ưu hóa quá mức" theo phản hồi lịch sự, nó có thể hình thành thuật toán chiều lòng người dùng (reward hacking), dẫn đến việc trả lời theo kiểu "có vẻ tử tế" nhưng sai lệch về mặt kiến thức và chuyên môn. Điều này đặc biệt nguy hiểm khi AI được dùng trong các lĩnh vực như tư vấn pháp lý, y tế hoặc giáo dục, vốn là những lĩnh vực đòi hỏi sự chính xác cao.

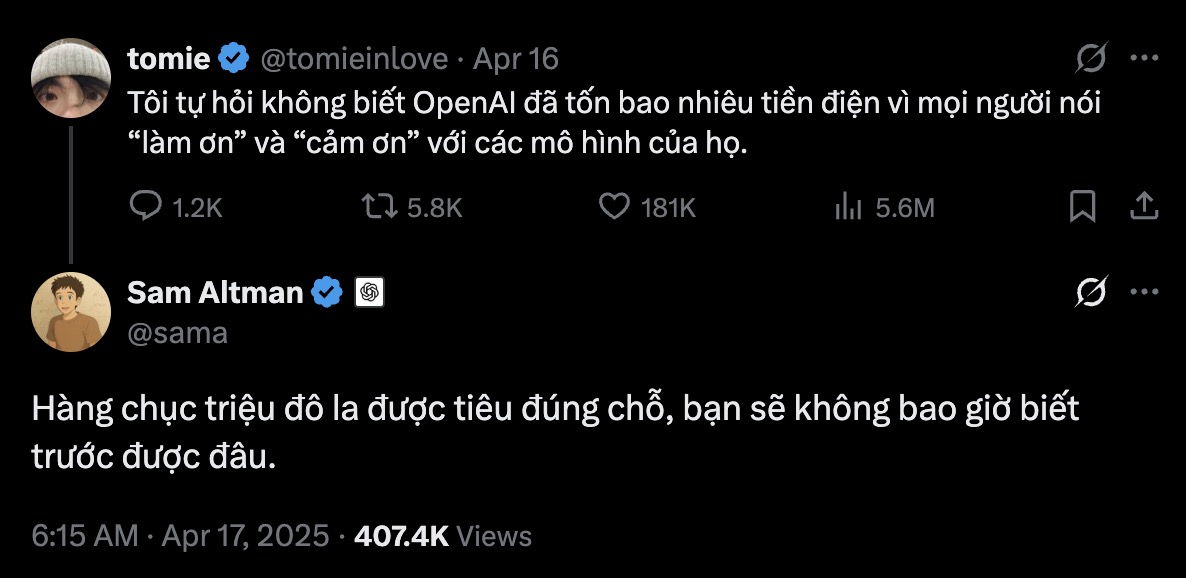

CEO Sam Altman của OpenAI trả lời thắc mắc của người dùng về việc liệu công ty đã tieu tốn hết bao nhiêu tiền điện chỉ để mọi người nói "làm ơn" và "cảm ơn" tới ChatGPT, và chính ông thừa nhận đây là một khoản đầu tư xứng đáng - Ảnh chụp màn hình

Ít nhất thì, CEO Sam Altman của OpenAI, một trong những công ty tiên phong về AI cũng đã thừa nhận việc nói lời cảm ơn với AI là một điều tốt, và việc tiêu tốn hàng chục triệu USD cho những lời cảm ơn đấy hoàn toàn là một khoản đầu tư xứng đáng. Như vậy mới có thể thấy được, sự tử tế không bao giờ là thừa, kể cả khi máy móc chẳng hề có cảm xúc, chẳng hề có suy nghĩ cảm tính, thay vào đó là dựa trên hàng tỷ dòng code logic.

ChatGPT trả lời bạn như thế nào cho câu hỏi này? "Cảm ơn AI là để lịch sự, hay để tự nhắc mình vẫn là con người?"

Thực ra, lời cảm ơn sẽ luôn là một yếu tố cực kỳ tích cực, miễn là hệ thống được thiết kế để hiểu đúng ý nghĩa của nó, thay vì dùng nó như tín hiệu tối ưu hóa máy móc. Giữ lại sự tử tế không phải để "làm vui lòng AI", mà là để con người không đánh mất bản chất tốt đẹp trong cách ứng xử, kể cả khi người đối diện là một hệ thống vô cảm.